KI & Ethik

Die Faszination für Künstliche Intelligenz (KI) hat einen Punkt erreicht, an dem Realität und überhöhte Erwartungen zunehmend verschwimmen. In einigen YouTube-Videos und Community-Foren werden Use Cases für ChatGPT vorgestellt, die weder den technischen Möglichkeiten noch ethischen Standards gerecht werden.

Noch alarmierender: Diese sogenannten "Use Cases" bergen nicht nur die Gefahr von Missverständnissen, sondern können in sensiblen Bereichen wie der Gesundheitsberatung erheblichen Schaden anrichten.

KI-Berater, die solche Use Cases als harmlose Spielereien präsentieren, tragen eine besondere Verantwortung. Sie ignorieren dabei, dass ihre Erklärungen direkten Einfluss auf das Vertrauen in die Technologie haben. Selbst wenn diese Beispiele als rein theoretisch dargestellt werden, können sie irreführend sein – insbesondere für Lernende, die die Grenzen der Technologie noch nicht einschätzen können.

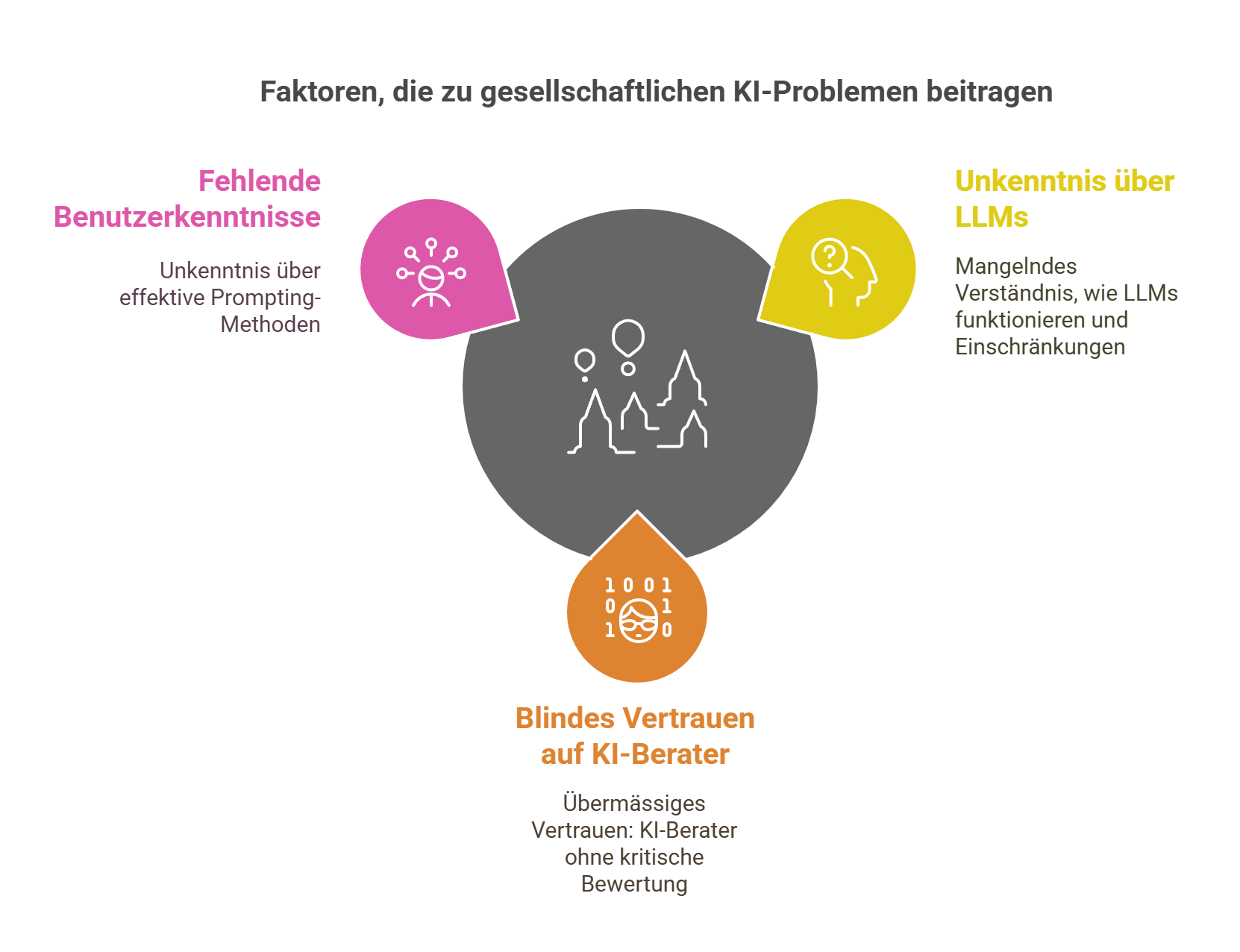

In Gesprächen und Medienberichten zeigt sich immer wieder, dass vielen Menschen die Funktionsweise von Large Language Models (LLMs) nicht bewusst ist. Diese Systeme generieren Antworten aus Datenmustern, ohne den Kontext oder die Nuancen komplexer Fragestellungen zu verstehen. Zudem können wir nicht davon ausgehen, dass alle Nutzer:innen mit fortgeschrittenen Prompting-Methoden vertraut sind.

Wenn Menschen blind den Empfehlungen solcher KI-Berater vertrauen, wird dies zu einem gesellschaftlichen Problem. Der Vertrauensvorschuss, der Technologie entgegengebracht wird, überdeckt oft die fehlende fachliche Expertise derjenigen, die diese Anwendungen vorantreiben. Die Folgen können gravierend sein.

Der Konflikt: Fragwürdige Use Cases und gefährliche Vereinfachung

KI-Systeme wie ChatGPT arbeiten ausschliesslich mit Datensätzen und Mustern. Sie können zwar generierte Antworten liefern oder Daten analysieren, aber die entscheidenden Nuancen bleiben ihnen verborgen.

Ein Beispiel: Wenn ein Blutbild hochgeladen wird, sieht die KI nur die vorhandenen Werte – nicht aber, welche wichtigen Marker fehlen oder wie diese im Gesamtkontext zu interpretieren sind. Oder wenn ein Foto des Kühlschrankinhalts analysiert wird, erkennt die KI nur musterhaft den Inhalt, nicht aber Details wie Ablaufdatum, Zusammensetzung oder Nährwert der Lebensmittel.

Die Brisanz wird noch deutlicher, wenn man bedenkt, dass solche Beispiele oft ohne klare Abgrenzung zwischen dem Potenzial und den Grenzen von KI präsentiert werden. Fragwürdige Use Cases wie "Ernährungspläne basierend auf Kühlschrankfotos" oder "KI-gestützte medizinische Diagnosen" suggerieren eine Sicherheit, die diese Technologien nicht leisten können.

Solche Aussagen untergraben die Bedeutung von Fachwissen und können im schlimmsten Fall gesundheitliche oder finanzielle Schäden nach sich ziehen. Sie verkennen nicht nur die Komplexität dieser Bereiche, sondern ignorieren auch die Verantwortung, die KI-Experten tragen.

Die gesellschaftlichen Folgen: Verantwortungslosigkeit durch KI-Berater

Diese Entwicklung hat weitreichende Folgen. Anbieter, die unrealistische Versprechen machen, nutzen die Unwissenheit der Menschen aus – und verdrängen gleichzeitig echte Experten, die auf fundiertes Wissen und Erfahrung setzen.

Menschen, die auf fragwürdige KI-Use Cases vertrauen, können langfristig Schaden nehmen – sei es durch ungeeignete Gesundheitspläne, falsche Diagnosen oder das Ignorieren von professionellem Rat.

Ein weiteres Problem ist der schwindende Respekt gegenüber Fachkräften. Wenn Berater, die keine ausreichende Expertise besitzen, KI-Systeme als Allheilmittel darstellen, wird das Vertrauen in echte Fachleute untergraben. Dies betrifft nicht nur den Gesundheitsbereich, sondern auch andere sensible Branchen, in denen Expertise durch Hype ersetzt wird.

Die Lösung: Ethik und Verantwortung für KI-Berater

Was kann getan werden, um diesen Entwicklungen entgegenzuwirken?

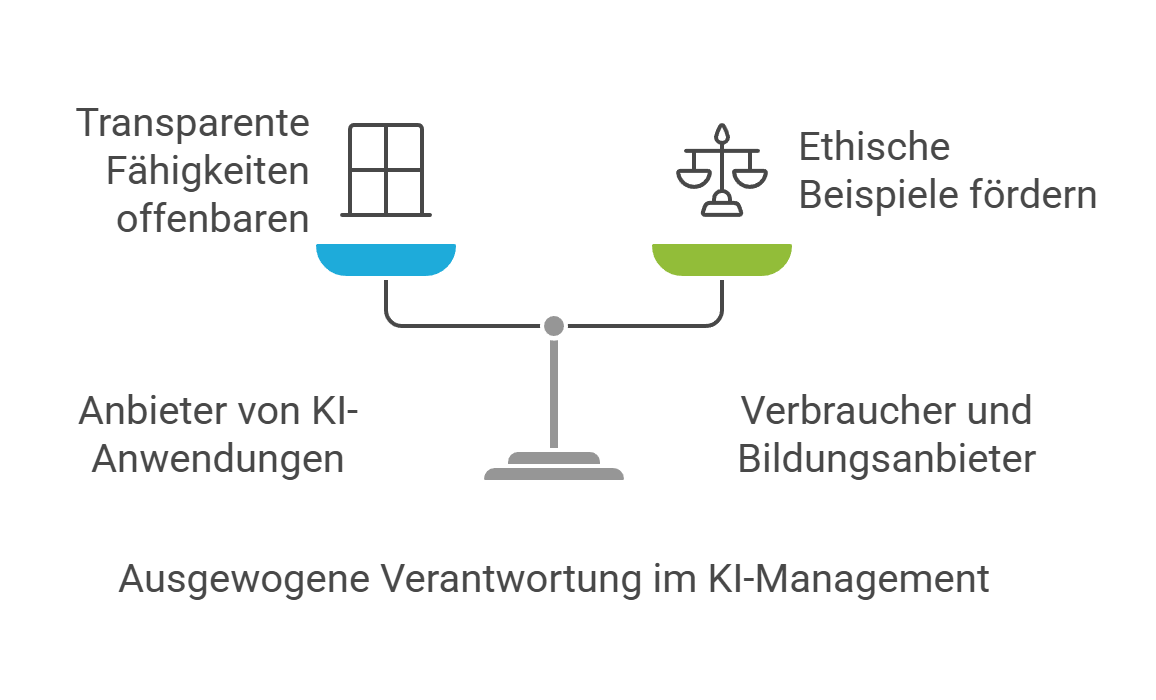

Anbieter, die KI-basierte Anwendungen bewerben, sollten verpflichtet sein, transparent darzulegen, was ihre AI Tools - die sie einsetzen - leisten können – und was nicht. Dafür braucht es zwingend vertiefende Kenntnisse im Bereich Künstliche Intelligenz und nicht nur, wie man sie anwendet.

Verbraucherinnen und Verbraucher sollten sensibilisiert werden: KI ist ein Werkzeug, kein Ersatz für fundiertes Fachwissen. Auch Bildungsanbieter, die mit KI-Use Cases arbeiten, tragen eine besondere Verantwortung. Hier ist sicherzustellen, dass die Beispiele, die sie präsentieren, ethisch vertretbar sind und keine falschen Erwartungen schüren.

Nur so kann verhindert werden, dass Menschen durch irreführende Anwendungen Schaden nehmen. Darüber hinaus braucht es eine gesellschaftliche Diskussion über den Umgang mit KI. Wie nutzen wir Technologien verantwortungsvoll? Wie stellen wir sicher, dass Expertise und Ethik nicht in den Hintergrund geraten?

Die Antworten auf diese Fragen erfordern einen Dialog zwischen Wissenschaft, Politik und Gesellschaft.

Fazit: Mehr Verantwortung, weniger Hype

Die Künstliche Intelligenz ist ein Werkzeug mit grossem Potenzial – doch sie hat Grenzen. Fragwürdige Use Cases und falsche Versprechen können nicht nur Schaden anrichten, sondern auch das Vertrauen in Technologie und Fachwissen untergraben.

Besonders KI-Berater tragen aus unserer Sicht eine immense Verantwortung, Grenzen klar zu kommunizieren und keine unrealistischen Erwartungen zu schüren.

Es liegt an uns als Gesellschaft, kritisch zu bleiben, Verantwortung zu fordern und echte Expertise zu würdigen. Denn nur so können wir sicherstellen, dass Technologie unseren Alltag bereichert, anstatt uns zu blenden.

Anmerkung:

Aus meiner Beobachtung und im Hinblick auf die Massenpsychologie der Kollektivseele zeigt sich, wie stark technologische Hypes unser Denken und Handeln beeinflussen können. Der Wunsch nach einfachen, schnellen Lösungen führt oft dazu, dass Menschen sich unreflektiert auf neue Technologien verlassen.

„Die Theorie von Gustave Le Bon über die Dynamik von Massenbewegungen, die er im 19. Jahrhundert in Psychologie der Massen entwickelte, zeigt interessante Parallelen zu aktuellen gesellschaftlichen Phänomenen. Obwohl seine Ansichten heute teils kritisch diskutiert werden, finde ich sie in der Analyse der Kollektivseele hilfreich, um die Dynamik moderner Hypes – wie beispielsweise im Bereich KI – besser zu verstehen.“

Gerade unseriöse KI-Berater nutzen diese Dynamik aus, indem sie überzogene Erwartungen schüren, um Bekanntheitsstatus zu erreichen, und kritische Nachfragen der Lernenden abtun. Daher ist es umso wichtiger, dass wir uns nicht von diesen falschen Versprechen leiten lassen, sondern stattdessen Verantwortung, Fachwissen und kritisches Denken fördern. Nur so können wir verhindern, dass die Grenzen der KI-Technologie und die Bedeutung menschlicher Expertise vernachlässigt werden.